La inteligencia artificial (IA) brinda una oportunidad generacional para los fabricantes de chips

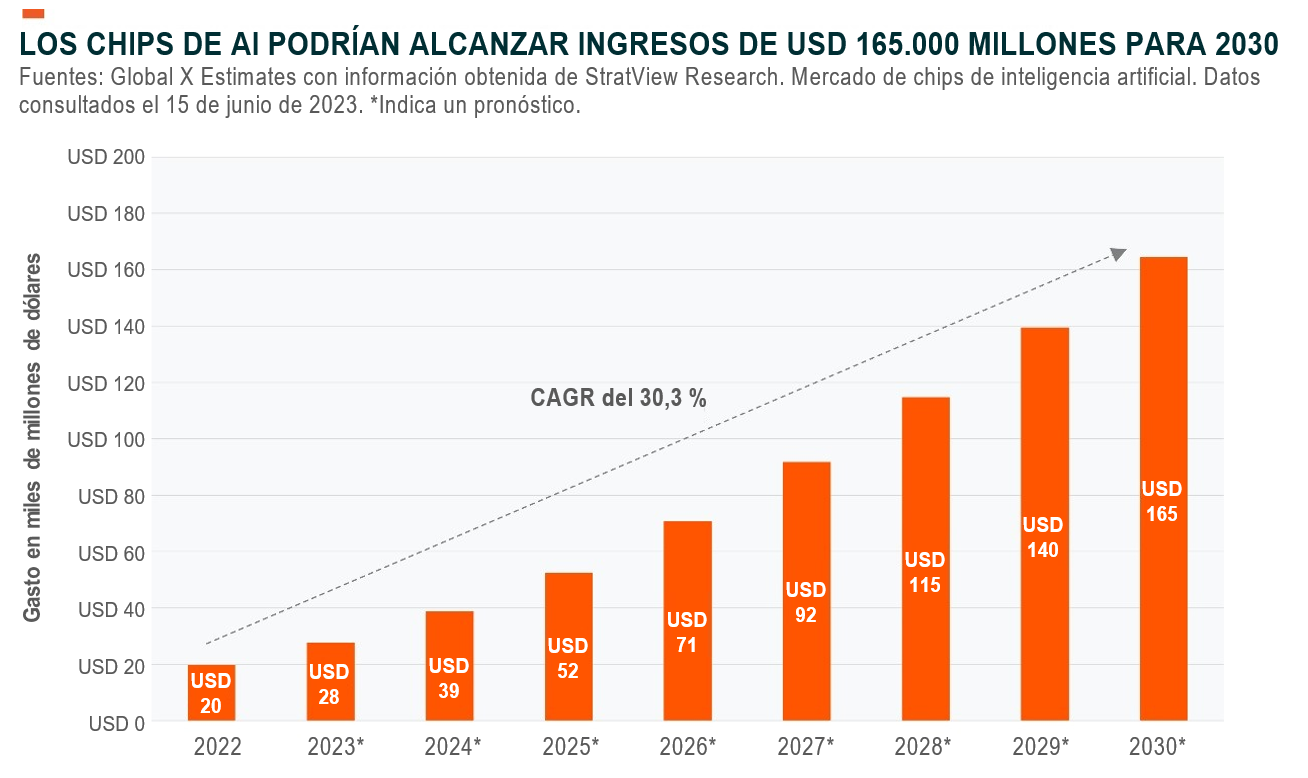

A medida que las aplicaciones de inteligencia artificial (IA) expanden su alcance, la infraestructura computacional existente tanto en centros de datos como a nivel perimetral requerirá un nuevo cableado que soporte las necesidades emergentes de computación con uso intensivo de datos. Este cambio había sido contemplado, pero es probable que la rápida proliferación y el gran potencial de los grandes modelos de lenguaje (LLM) aceleren el cronograma. Para fines de esta década, se proyecta que el gasto anual en chips de IA crezca a una tasa de crecimiento anual compuesto (compound annual growth rate, CAGR) de más del 30 % a casi USD 165.000 millones.1 Los proveedores de chips basados en unidades de procesamiento gráfico (Graphic Processing Units, GPU) obtendrán más beneficios y seguirán siendo la opción principal, impulsada por el rendimiento superior y la preferencia de los desarrolladores. Otros componentes de hardware relacionados, incluida las memorias y los equipos de red, también podrían beneficiarse de esta fase.

Conclusiones clave

- Las aplicaciones de IA están ampliando su alcance y requerirán una nueva infraestructura informática, lo que conducirá a una inversión significativa en chips de IA, memoria y equipos de red.

- Si bien la mayoría de los chips de IA van a los centros de datos y a las redes perimetrales, los procesadores de IA basados en dispositivos también podrían volverse comunes, con lo cual se abrirán nuevos mercados para los proveedores de chips.

- Los proveedores de infraestructura de IA están buscando inversiones y alianzas para protegerse contra la escasez.

El gasto en infraestructura se muestra fuerte a medida que aumenta la demanda de servicios de IA

Los grandes modelos de lenguaje se convirtieron en la tendencia dominante en 2023. Los modelos fundamentales como GPT-4, disponibles tanto como interfaces de programación de aplicaciones (application programming interfaces, API) como a través de interfaces basadas en chat, están catalizando un torbellino de actividad de usuarios y de desarrolladores, lo que convierte a la IA en un campo de batalla definitivo tanto para las empresas de tecnología como para aquellas ajenas a este ámbito.

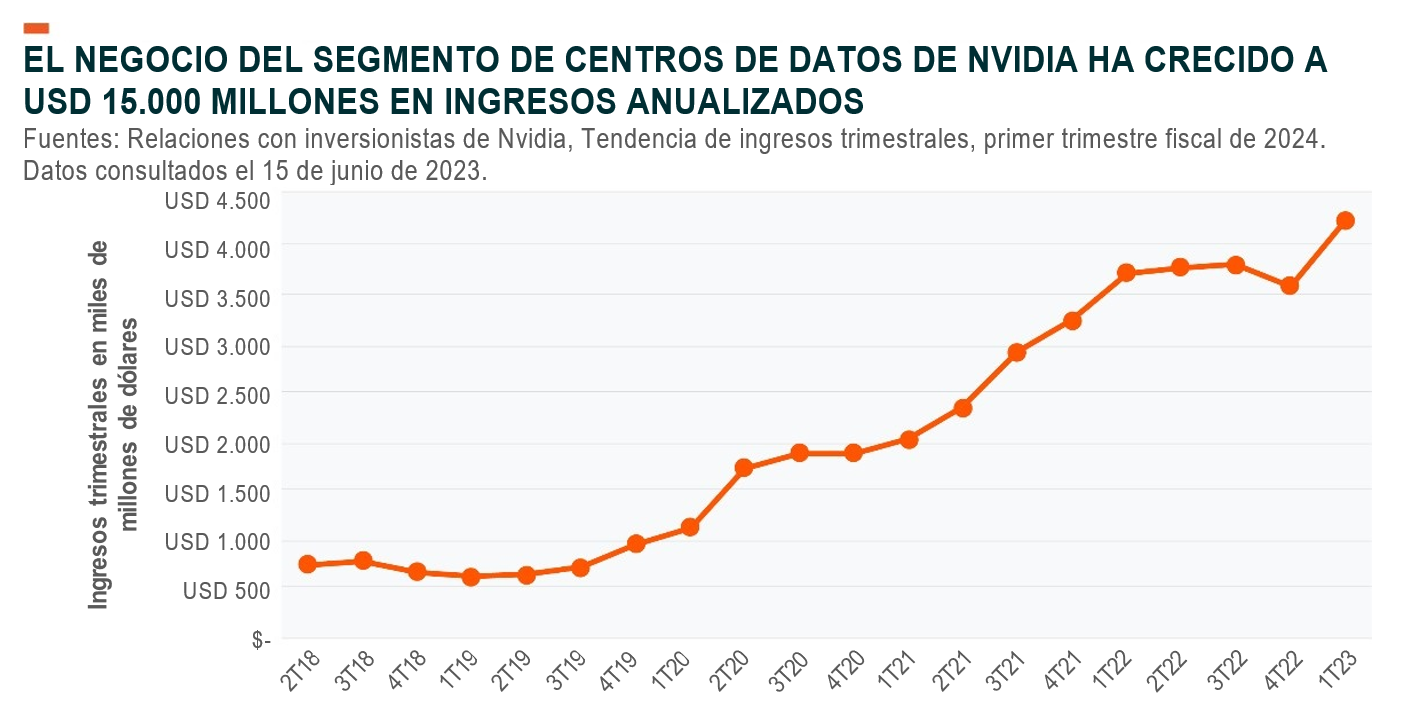

A medida que la adopción cobra fuerza, también lo hace la demanda de proveedores de infraestructura de IA. Nvidia, uno de los principales proveedores de chips para capacitar modelos de IA, aumentó sus ingresos en el segmento de centros de datos en casi un 14 % interanual en el primer trimestre de 2023, y revisó la orientación al alza en más del 50 % interanual para el segundo trimestre.2 De manera similar, la gerencia de Microsoft afirmó que, aunque el crecimiento en su nube general se está enfriando ampliamente, se espera que las cargas de trabajo de IA como servicio y aprendizaje automático impulsen el crecimiento a corto plazo.3

La demanda de IA plantea inquietudes sobre la disponibilidad sostenida del hardware de IA necesario para capacitar, evaluar e implementar modelos.4 Creemos que probablemente estamos ante el comienzo de un posible ciclo de inversión de capital largo que impulse un crecimiento récord para los proveedores de hardware e infraestructura de IA. Una parte importante de ese gasto se destinará a reemplazar las pilas de computación heredadas en los centros de datos y a nivel perimetral con hardware compatible de manera efectiva con la computación con uso intensivo de datos y la amplia adopción de la IA.

Los proveedores de servicios en la nube a hiperescala aumentaron la infraestructura de capital con tasas de crecimiento superiores al 20 % en los últimos cinco años, lo que respalda las amplias tendencias de transformación digital empresarial.5 Igualmente, el crecimiento en las mejoras de infraestructura basadas en IA podría aumentar en los próximos cinco años, creando una oportunidad excepcional para los proveedores de semiconductores para centros de datos.

La inteligencia artificial hace que las GPU sean imprescindibles

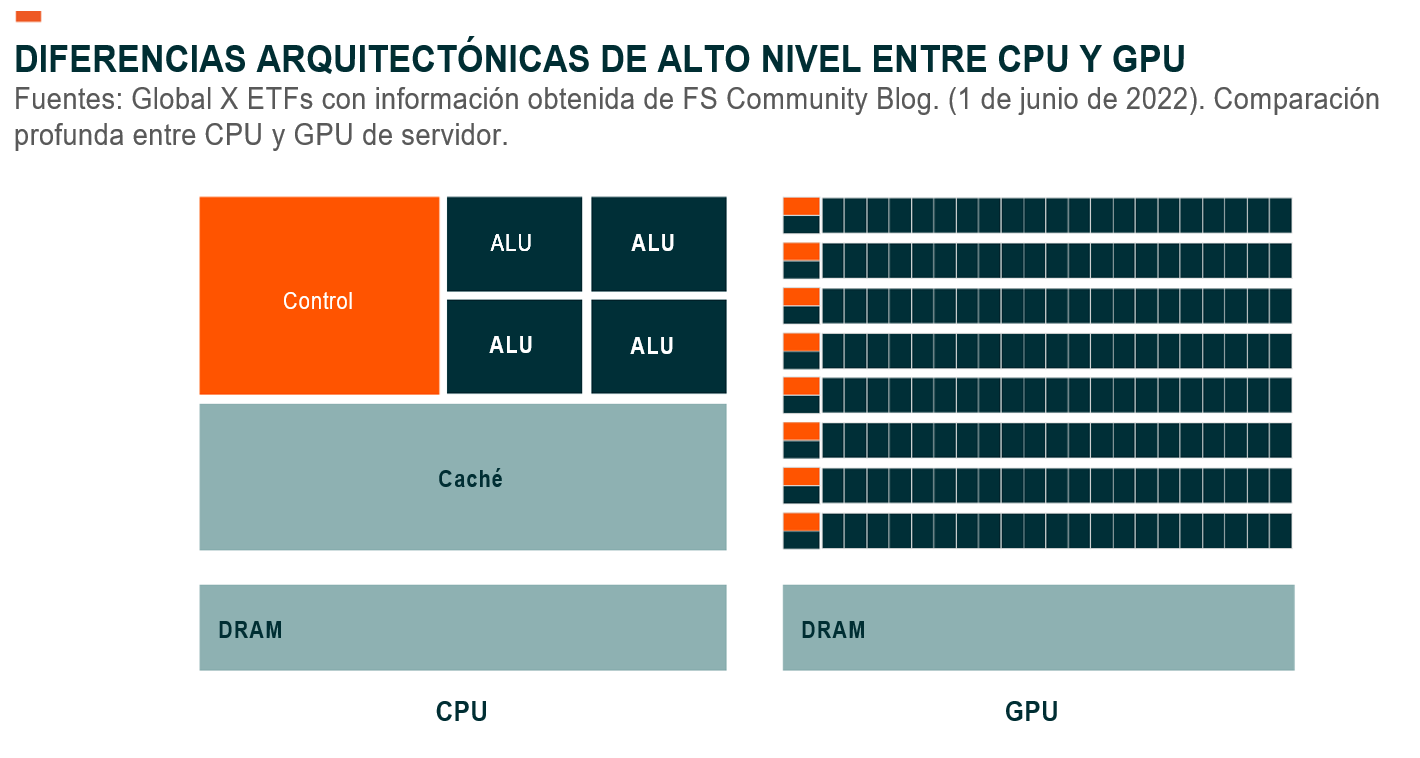

Los procesadores tradicionales, también conocidos como CPU, fueron diseñados para realizar tareas de computación de uso general de manera eficiente en un solo ciclo.6 Las GPU están diseñadas específicamente para procesar cálculos múltiples menos complejos pero basados en la lógica de forma paralela, lo que los hace increíblemente eficientes para el procesamiento de datos pesados y, por lo tanto, populares para las tareas de capacitación e inferencia de IA.7

Casi USD 16.000 millones de valor en GPU se destinaron a ejemplos de uso relacionados con la aceleración de la IA en todo el mundo en 2022.8 Nvidia es el proveedor dominante, al poseer casi el 80 % de la participación en el mercado de la aceleración de IA basada en GPU.9 Las inversiones de Nvidia en marcos de software, incluida la arquitectura de CUDA, garantizan que los desarrolladores e ingenieros puedan aprovechar la eficiencia computacional de las GPU, lo que le brinda a la empresa una ventaja sostenida sobre su competencia, que carece de soporte de software similar.

Fuera de las GPU, las matrices de puertas programables en campo (field-programmable gate arrays, FPGA) y los circuitos integrados específicos de una aplicación (application-specific integrated circuits, ASIC) conforman el resto del mercado de chips de IA. Juntos, las FPGA y los ASIC registraron ventas de aproximadamente USD 19.600 millones para 2022, con un crecimiento estimado del 50 % interanual.10 En los próximos ocho años, se espera que el gasto combinado crezca a una tasa de crecimiento anual de casi el 30 % hasta alcanzar los USD 165.000 millones para 2030.11

A medida que los chips de IA ganan prominencia dentro de los centros de datos, creemos que el gasto en CPU prémium podría disminuir a medida que las CPU pasan de ser la unidad de procesamiento principal a una simple unidad de control, cuya función esencial sería dirigir y distribuir cargas de trabajo entre clústeres de GPU. Esta dinámica ejercería presión sobre los proveedores de centros de datos prémium como Intel, que construyó franquicias multimillonarias con la venta de CPU durante las últimas tres décadas, mientras se inclinaría ese mercado a favor de proveedores de CPU de bajo costo como Qualcomm y Marvell.

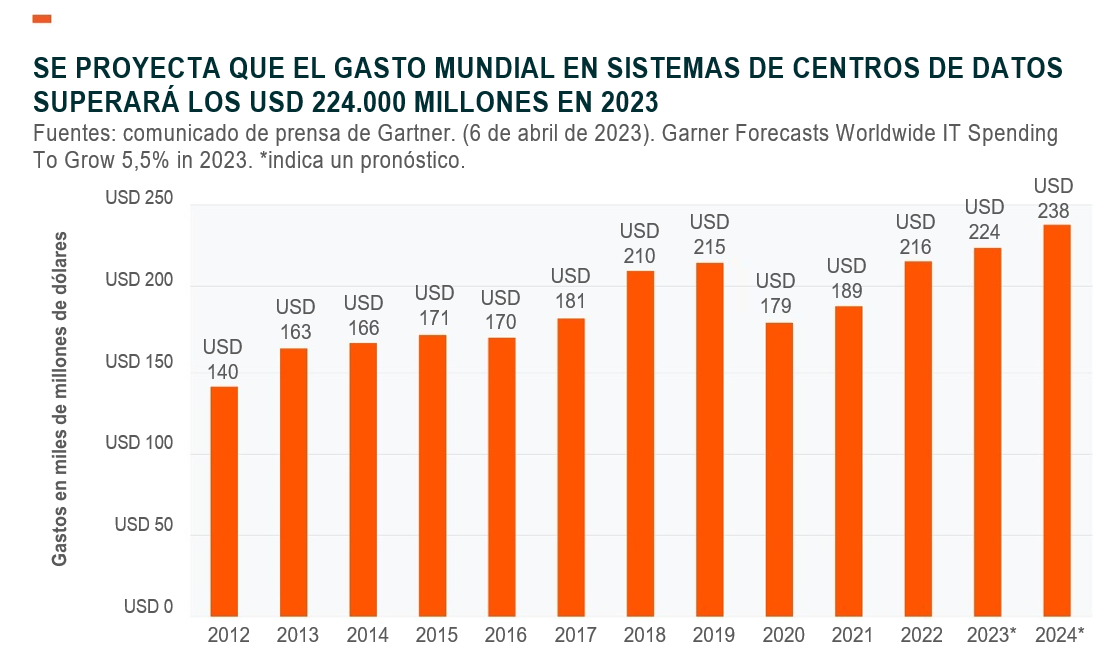

Los compradores de TI gastan cerca de USD 224.000 millones en sistemas de centros de datos anualmente, incluidos procesadores, memoria y almacenamiento, componentes de red y otros productos de hardware.12 Suponiendo que los sistemas de centros de datos se reemplazan cada cuatro años, es probable que más de un billón de dólares en infraestructura computacional estén listos para ser reemplazados en los próximos años, lo que presenta una oportunidad generacional para que el hardware que priorice la IA gane terreno en medio de una rápida adopción de soluciones de IA generativas.

Fuera de los centros de datos y los ejemplos de uso de computación de alto rendimiento, los chips de IA en vehículos para conducción autónoma, la computación perimetral y los dispositivos móviles podrían aumentar aún más la demanda de hardware especializado, incluidos equipos de red, memoria de alta velocidad y sistemas de enfriamiento.

Los temores a la escasez de chips pueden estimular las inversiones y las alianzas

Los desarrolladores e ingenieros se apresuran a llevar al mercado los productos que priorizan la IA en medio de una escasez de hardware de procesamiento de IA. Los pedidos de nuevas GPU tienen un retraso de seis meses, y los precios de las líneas A1000 y H1000 de GPU de Nvidia se han disparado significativamente, con chips que se venden en mercados secundarios a un sobreprecio elevado.13,14

Anticipándose a una crisis de suministro y a una dependencia excesiva de los proveedores de chips, los hiperescaladores han estado trabajando en el desarrollo de su propio hardware de procesamiento de IA, y esta capacidad interna está demostrando ser fundamental para satisfacer la demanda de IA generativa. Por ejemplo, Alphabet ejecuta su sistema de IA Bard con chips diseñados de forma nativa llamados unidades de procesamiento tensorial (Tensor Processing Units, TPU), que también están disponibles para clientes externos a través del servicio Google Cloud.15 Microsoft también ha estado trabajando en su propio chip de IA junto con una CPU basada en ARM de bajo costo.16 Las empresas del mercado privado también quieren capitalizar la inminente escasez de hardware de IA. En los últimos cinco años, se han invertido más de USD 6.000 millones de capital externo en empresas de chips de IA.17

Las alianzas son otra tendencia creciente para sortear la escasez de chips. Microsoft llegó a un acuerdo de varios miles de millones de dólares con el proveedor de GPU como servicio Core Weave, que compra y luego suministra energía de GPU como servicio al mercado más amplio.18 Amazon Web Services se asoció con Nvidia para permitir un acceso predecible y estable a las GPU Hopper de Nvidia para los clientes en la nube de Amazon. Las instancias especializadas combinarán el hardware de Nvidia con las soluciones de escalabilidad y redes de AWS para ofrecer hasta 20 exaflops de rendimiento informático para desarrolladores.19

La IA aún se encuentra en su fase inicial de innovadores y experimentación, por lo que la mayor parte de la demanda de hardware proviene de empresas tecnológicamente avanzadas en este momento. No obstante, creemos que toda la cadena de valor de los semiconductores, incluidas las fundidoras, los diseñadores de chips y los proveedores de equipos para semiconductores, pueden beneficiarse a corto plazo a medida que la IA va extendiéndose. Es probable que los mercados multibillonarios, como la publicidad, el comercio electrónico, los medios digitales y el entretenimiento, los servicios en línea, las comunicaciones y la productividad, aumenten el gasto en configuraciones de hardware preconfigurado también. También creemos que es probable que la industria sea propensa a actividades de negociación, con grandes proveedores de aceleradores que buscan adquirir empresas de componentes adyacentes para consolidar la investigación y el desarrollo, así como la innovación de productos.

Conclusión: no hay IA sin hardware de IA especializado

El boom de la IA probablemente estimulará un ciclo de mejoras en los centros de datos que favorece una nueva pila de computación con la GPU en su núcleo. La rápida proliferación de LLM probablemente dará lugar a una demanda exponencial de procesamiento de IA y a un gasto acelerado en chips especializados, lo que podría abrir un mercado de más de cien mil millones de dólares para las GPU en un futuro cercano.20 Mientras tanto, los grandes hiperescaladores de la nube probablemente continuarán invirtiendo en I+D para construir e implementar chips propios, en un intento por reducir su dependencia ante grandes proveedores de chips y reducir los costos. La demanda de chips de IA puede ser irregular, pero creemos que la cadena de valor de semiconductores está bien posicionada para aprovechar esta oportunidad y crear una posible alternativa de inversión a medida que la IA penetre en nuevos mercados.